SWALP: Stochastic Weight Averaging in Low-Precision Training

预备知识

- 对 Fully Quantized Quantization (FQT) 有个基本的了解.

核心思想

Low-precision training 能够加速模型训练 (且往往消耗更少的显存), 因为是相当重要的研究课题. 但是, 被人诟病的是它的不稳定性以及所导致的性能下降.

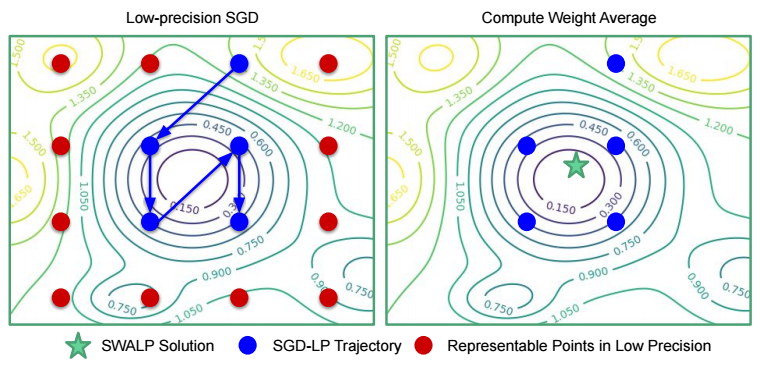

上述的一个很大问题可能是低精度下收敛的振荡导致的 (因为实际上有了更多的噪声), 作者建议通过 SWA (Stocastic Weight Averaging [2]) 来稳定.

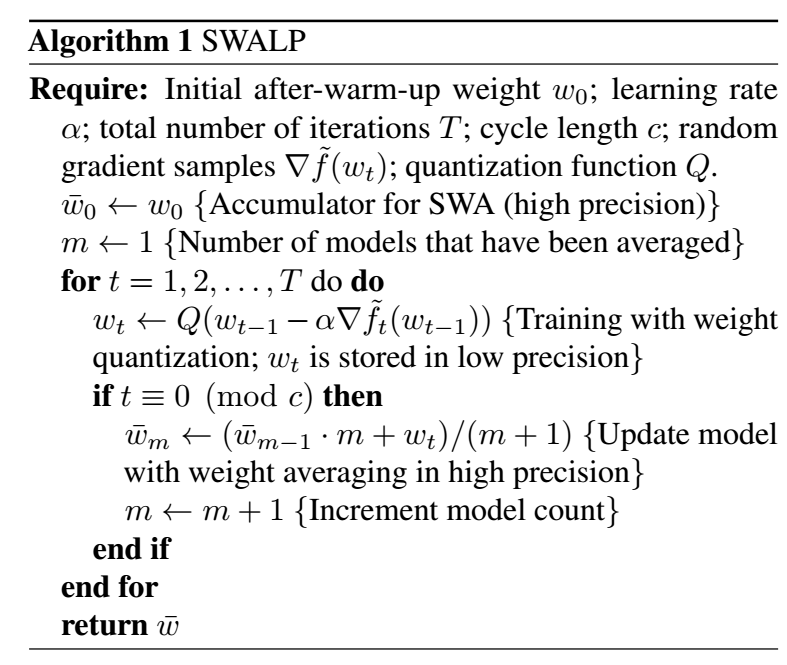

- 如上图所示, 权重 $w$ 由于低精度的原因在最优点附近振荡, 这个时候通过 SWA 可以使得平均后的结果更为接近最优点, 其算法如下:

参考文献

- Yang G., Zhang T., Kirichenko P., Bai J., Wilson A. G., and Sa De C. SWALP: Stochastic Weight Averaging in Low-Precision Training. ICML, 2019. [PDF] [Code]

- Izmailov P., Podoprikhin D., Garipov T., Vetrov D., and Wilson A. G. Averaging Weights Leads to Wider Optima and Better Generalization. arXiv, 2018. [PDF] [Code]